近日拜读了 guizang 老师关于 #Obsidian 的精彩博文(链接),不禁勾起了我与这款强大笔记软件的点滴回忆。曾几何时,我也曾希望借助 Obsidian 打造属于自己的知识宝库,然而那时浅尝辄止,笔记散落各处,未能成体系,实属憾事。

在信息爆炸的时代,Readwise、Cubox、Flomo 等工具层出不穷,各具优势,却也让信息碎片化,分散在各个角落,检索整合颇为不便。痛定思痛,我决定重新出发,以 Obsidian 为核心,系统整合博客草稿、网页剪藏、读书笔记等各类信息流,构筑一座真正属于自己的知识殿堂。

安装 Obsidian:万丈高楼平地起

第一步自然是迎接主角登场。从 Obsidian 官方网站下载最新版本进行安装,不再赘述。

配置网页剪藏:信息输入的第一站

信息的高效输入,是知识管理的起点。参考 guizang 老师的经验,选择了OB 的官方网页剪藏工具,通过插件和配置的API接口,将网上的灵感、资料快捷地导入 Obsidian,确保信息流顺畅汇入知识库。

搭建云端同步:多端无缝,数据无忧

为了实现多设备间的无缝切换与数据安全,稳妥的同步方案必不可少。我采用了 remotely-sync 插件,结合 OneDrive 云存储,实现笔记库的自动同步与备份。其实也可以用 cloudflare 的 R2 存储,不过我的 OneDrive 容量大,不用白不用。其次国内的同步速度还 OK。

构建图片存储方案:图文并茂,行云流水

图片管理是 Obsidian 使用中常见的难题。为了获得更优体验,我选择了 Cloudflare R2 作为图床,并进行了以下配置:

图床配置

相关文章比较多,不赘述,参考使用 Cloudflare R2 存储桶搭建图床 | Esing 的小站

上传工具

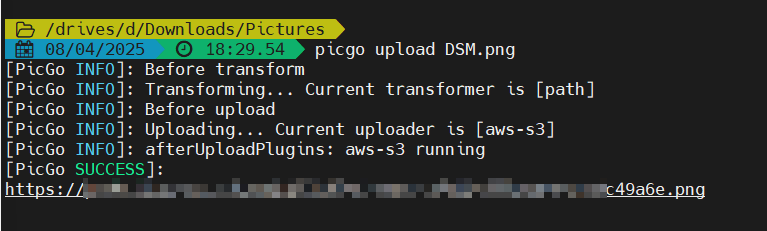

摈弃图形界面的 PicGo App,转而使用更为轻便高效的 PicGo Core 命令行工具,简单高效。 官网链接

全局安装

npm install picgo -g配置 R2 picgo core 本身不支持

S3,所以这里借助picgo-plugin-s3项目,在 PicGo Core 中配置好 Cloudflare R2 的访问凭证和存储桶信息。

安装插件 picgo set uploader aws-s3

参考配置

| |

配置完成后,可以测试下,看看地址是否与 R2 上的地址匹配,如果上传成功,但是生成的链接不一致,应该是 outputURLPattern 的设置问题,请参考项目文档进行修改;

自动上传

在 Obsidian 中安装 obsidian-image-auto-upload-plugin,实现复制粘贴图片时自动上传到 R2 图床,免去手动操作的繁琐。

遇到个小坑

配置过程中,在 macOS 下遇到 PicGo 命令无法识别的情况。参考相关 Issue,将插件命令设置为export PATH="/opt/homebrew/bin:$PATH" && /opt/homebrew/bin/picgo u,成功解决问题。

尾声:重塑知识管理的起点

至此,Obsidian 的核心配置告一段落。这不仅是一场工具的升级,更是对个人知识管理体系的重塑。前路漫漫,唯有日拱一卒,方能将这片知识的土地耕耘成丰饶的园地,滋养心智,助力成长。未来,愿与 Obsidian 共同书写属于自己的精彩篇章。

相关链接

- guizang 老师 Obsidian 经验分享:

https://mp.weixin.qq.com/s/VRQ_QWjuUqvJC8FeAZgvzw picgo-plugin-s3插件:

https://github.com/wayjam/picgo-plugin-s3/tree/mainobsidian-image-auto-upload-plugin插件:

https://github.com/renmu123/obsidian-image-auto-upload-plugin- PicGo 路径问题讨论:

https://github.com/renmu123/obsidian-image-auto-upload-plugin/issues/20